Одна из самых производительных видеокарт 2012-го года, Nvidia Geforce GTX 680, комплектовалась графическим процессором GK104, благодаря чему легко справляется с запуском не слишком старых игр и видео в формате до 4К. В своё время она стала достойным конкурентом модели Radeon HD 7970 и всех остальных высокопроизводительных однопроцессорных видеокарт. В 2018-м году она уже не может использоваться для сборки мощного или даже среднего по параметрам геймерского компьютера, однако вполне подходит для бюджетных игровых ПК.

Видеокарта получила от производителя графику GPU GK104 с 1536 ядрами CUDA (в 3 раза больше по сравнению с моделью GTX 580) и 128 текстурными блоками.

Остальные характеристики GTX 680 можно представить следующим списком:

- базовая частота процессора/памяти – 1006/6008 МГц;

- объём памяти – 2048 Мб;

- техпроцесс – 28 нм;

- число транзисторов – 3,54 млрд., больше по сравнению с GTX 580, но заметно меньше, чем у Radeon HD 7970;

- ширина шины памяти – 256 бит;

- интерфейс – PCI-E 3.0.

С помощью видеокарты можно подключать к одному компьютеру до 4 экранов без специальных проводников, три из них – в режиме 3D Vision Surround. Для подключения могут использоваться 2 порта DVI (DVI-I и DVI-D), HDMI и DisplayPort. Максимальное разрешение дисплея в этом случае – 3840×2160 пикселей.

Продажная цена GTX 680 в самом начале составляла $499 или 17999 руб. для России. Эта стоимость заметно ниже по сравнению конкурентов типа Radeon HD 7970. Узнавая, сколько стоит видеокарта GTX 680 сейчас, можно получить цифру примерно на уровне $100–150.

Обзор GTX 680

На вид графическая карта ненамного отличается от предыдущей версии GTX 580. Особенно, с учётом использования массивного кулера-турбины и другим особенностям системы охлаждения.

Для экономии пространства с платы убрали испарительную камеру. Рёбра радиатора сделали более скошенными, облегчив прохождение воздуха. Эта особенность и использование для изготовления турбины специального звукопоглощающего материала приводит к заметному снижению шума от кулера, если сравнивать с 580-й версией или Radeon HD 7970.

Среди других особенностей модели стоит отметить:

- наличие полноразмерных портов DisplayPort и HDMI, позволяющих обойтись без переходников;

- меньшее количество микросхем памяти на плате по сравнению с конкурентами;

- отсутствие теплораспределителя на графическом процессоре, позволяющее избежать сколов при установке кулера.

Как разогнать видеокарту Nvidia Geforce GTX 680

Выполняя разгон GTX 680, можно попробовать увеличить её производительность в играх и даже использовать эту карту для добычи криптовалюты. Для этого применяется специальная технология GPU Boost и одна из утилит, подходящих для графических процессоров Nvidia – например, MSI Afterburner или RivaTuner.

При увеличении напряжения питания видеоадаптера на 10% можно получить частоту 1100 МГц (вместо 1006) и эффективное значение на уровне 6912 МГц (вместо 6008). Результатом такого разгона стало незначительное увеличение нагрузки на систему охлаждения, кулеры которой стали работать с максимальным количеством оборотов.

При использовании графического адаптера в играх производительность выросла примерно на 7-13%, в зависимости от настроек.

Если сравнивать возможности GTX 680 в майнинге, до разгона она показывала значение 15 Mh/s для Эфириума, после повышения частоты – около 16,2 Mh/s.

Такой уровень не слишком высокий и примерно соответствует графическим картам GTX 1050, хотя у более новой модели от Nvidia меньше энергопотребление, а значит майнить выгоднее.

При сравнительно невысокой стоимости электроэнергии майнинг на GTX 680 принесёт определённую прибыль отечественному пользователю. Хотя покупать эту карту специально для таких целей нецелесообразно – на рынке можно найти варианты с более выгодным соотношением затрат к скорости добычи криптовалют.

Тестирование в играх

Проверяя FPS GTX 680 в играх, можно получить представление о её возможностях и принять решение по поводу покупки карты. Удобнее всего сделать это, тестируя самые требовательные к ресурсам игровые приложения на момент выпуска модели и в настоящее время. Причём, используя её вместе с соответствующими ЦПУ (Core i5 или i7) и памятью (не меньше 6–8 Гб).

При запуске с помощью видеоадаптера современных игр были получены такие результаты:

- для Lost Planet 2 – игры, в которой активно используется 3D-графика и происходит постоянное наложение карт смещения с геометрическими объектами, – GTX 680 показывает 52 кадра в секунду;

- при запуске ещё более требовательной к характеристикам компьютера игры Metro 2033 с разрешением FullHD можно получить значение около 25 FPS – неплохо для комфортного игрового процесса, однако практически на грани;

- в игре DiRT 3 показатели GTX 680 составляют около 74 кадров в секунду, хотя эта игра уже не может продемонстрировать все возможности графики;

- для Mafia II FPS карты достигает 50 даже без разгона, для разогнанной карты значение увеличивается примерно на 12%;

- на максимальных настройках в шутере Aliens vs. Predator видеоадаптер показывает 32 FPS;

- для технологического шутера Hard Reset значения FPS получились самыми впечатляющими – при запуске игры на высоких настройках частота достигает 83 кадр/с;

- при попытке поиграть в одну из последних частей стратегии Total War, Shogun 2, видеокарта снова получает приличное значение частоты – 106 кадр/сек;

- в игре Batman: Arkham City при разрешении 1650х1080 видеоадаптер показывает 27 FPS.

При запуске с помощью GTX 680 современных игровых приложений показатели падают. Однако на средних и минимальных настройках всё равно запускаются почти все игры.

Например, в Assasin Creed: Origins при запуске с процессором Core i7 и 6 Гб ОЗУ она обеспечит плавный игровой процесс с разрешением 1280х720. На невысоких настройках запустится и Kingdom Come: Deliverance, игра 2018 года, хотя для нормальной работы понадобится 8 Гб оперативной памяти.

Обновление драйверов

Отсутствие подходящего для GTX 680 драйвера приводит к проблемам с работой требовательных к ресурсам игр и других полезных программ. На экране компьютера будут появляться сообщения об ошибке, компьютер начнёт зависать и работать медленнее, чем должен. Решение проблемы заключается в скачивании подходящего программного обеспечения с официального ресурса производителя – компании Nvidia.

Можно воспользоваться для обновления драйвера и другими сайтами, в надёжности которых уверен пользователь. Не рекомендуется скачивать и устанавливать ПО для видеокарты со сторонних ресурсов – результатом нередко становится заражение компьютера вирусом. Нежелательно делать это и с помощью специальных утилит, использование которых может привести и к установке устаревших драйверов, и к попаданию на ПК вредоносных программ.

«…Назвать GTX 680 безоговорочным лидером невозможно. По производительности карта ненамного опережает HD 7970. Пожалуй, единственное преимущество Kepler - технологичность. Автоматический разгон по запасу TDP, оригинальные режимы сглаживания, возможность иг

Игромания https://www.сайт/ https://www.сайт/

Компания NVIDIA вступила в гонку видеокарт нового поколения. В конце марта этого года в продаже появилась GeForce GTX 680 — главный конкурент AMD Radeon HD 7970. Сейчас мы расскажем, что скрывается под кодовым названием Kepler, сколько ядер получил свежий кристалл и на какой частоте он работает. Ну и, конечно, ответим на извечный вопрос: кто быстрее, «зеленые» или «красные»?

Реорганизация

Архитектура Fermi , на которую делали ставку последнюю пару лет, себя исчерпала. На смену ей пришла Kepler. На первый взгляд все по-прежнему: потоковые процессоры объединяются в SM-модули, те, в свою очередь, образуют кластеры GPC, и уже из них собирается GPU. Но если в GF110 (GeForce GTX 580 ) каждый SM-модуль оснащался 32 CUDA-ядрами, то в Kepler их стало в шесть раз больше — 192 штуки. Прибавилось в растолстевших блоках (теперь они называются SMX) и вспомогательных элементов: «текстурников» отныне 16 вместо 4, а наборов специальных операций — 32 против 4 SFU у предыдущего флагмана.

Пара SMX и один растеризатор формируют GPC (Graphics Processing Cluster). Четыре таких комплекта составляют основу чипа GK104 — сердца GTX 680. Таким образом, новый GPU несет на борту 1536 ядер и 128 «текстурников», в то время как GF110 довольствовался 512 процессорами и 64 TMU. А вот число PolyMorph Engine, отвечающих за тесселяцию, сократилось: 8 против 16 штук у прошлого поколения. Мало? Как бы не так. Разработчики не только пересмотрели принципы функционирования PM Engine, но и добавили мегагерц. Так что, по словам инженеров, общая производительность выросла примерно на 28%.

А вот от чего в Kepler отказались — разделение частот. В Fermi потоковые процессоры работали на удвоенной скорости камня, теперь цифры сравнялись. С одной стороны, это хорошо: основные элементы GK104 получили нехилую дозу адреналина. С другой — заметно упала итоговая мощность отдельно взятого CUDA-ядра.

Еще одна потеря — шина памяти. GK104 оснащен четырьмя 64-битными контроллерами GDDR5, так что разрядность равна 256 против 384 бит у GF110 и Thaiti на Radeon HD 7970. Меньше теперь и ROP: 32 вместо 46 единиц у GTX 580.

Новые возможности

С Kepler представили несколько свежих технологий. Первая — GPU Boost . Она следит за температурой и энергопотреблением и, если показатели не превышают критических значений, автоматически повышает скорость и напряжение кристалла. Работает все это на аппаратном уровне и не отключается даже во время ручного разгона.

Вторая — возможность подключить сразу четыре монитора. При этом для 3D Vision Surround (игры на трех дисплеях) больше не нужна SLI-связка, хватит одной GTX 680.

Третья — дискретный чип кодирования видео NVENC . Карты NVIDIA и раньше неплохо справлялись с обработкой видеопотоков, но использовали для этого вычислительную мощь CUDA-ядер. Теперь они играют лишь вспомогательную роль: основные расчеты выполняет новый модуль и делает это в четыре раза быстрее Fermi. Слабое место NVENC — он знаком лишь с кодеком H.264.

Четвертая — свежие алгоритмы сглаживания, TXAA и FXAA . Последний — «дешевая» замена традиционному MSAA. Влияние на производительность минимально, но расплачиваться приходится легкой размытостью картинки. TXAA — более серьезный подход, и, если верить разработчикам, он не только превосходит MSAA по качеству, но и требует меньше ресурсов.

Наконец, пятая — режим адаптивной вертикальной синхронизации. Здесь все просто: VSync активируется, только когда fps превышает развертку экрана. Как следствие, проседание фреймрейта ниже заветного порога больше не приводит к резкому падению скорости.

Хладнокровный

Несмотря на трехкратное увеличение числа потоковых процессоров, количество транзисторов, используемых для построения чипа, возросло незначительно — с 3 до 3,54 млрд. Благодаря новому 28-нм техпроцессу площадь ядра и уровень энергопотребления получились небольшими. Даже при максимальной нагрузке TDP не превышает 195 Вт, и это когда базовая частота достигла фантастической отметки в 1006 МГц, а под GPU Boost поднимается до 1058 МГц! Для сравнения: Radeon HD 7970, работающая на 925 МГц и несущая на борту 4,31 млрд транзисторов, потребляет 250 Вт.

Холодный нрав GK104 позволил упростить дизайн платы. У GTX 680 нет разъема 8-pin PCIe, столь любимого топовыми решениями, — хватило пары 6-контактных розеток. На питание кристалла выделено лишь четыре фазы, и, судя по разводке, от пятой отказались в последний момент. Длина карты — 25 см, что немного меньше, чем у флагманских GeForce предыдущих поколений.

Новинка комплектуется восьмью модулями GDDR5 общей емкостью 2 Гб. Скорость памяти равна рекордным 6008 МГц, что частично компенсирует низкую разрядность шины. Задняя панель оснащена одним HDMI 1.4a с DisplayPort 1.2 и парой DVI. В качестве интерфейса используется PCIe 3.0, с обратной совместимостью с PCIe 2.0.

За охлаждение отвечает двухэтажная турбина. Она включает в себя крупный алюминиевый радиатор с тремя тепловыми трубками и необычную для «зеленых» цилиндрическую вертушку, в конструкции которой используются звукопоглощающие материалы.

Первые в мире

Плату мы получили напрямую из российского офиса NVIDIA. Внешний вид карты стандартный: вся поверхность закрыта черным пластиковым кожухом и украшена фирменными логотипами. По габаритам GTX 680 действительно чуть меньше своей предшественницы и выглядит очень аккуратно. Из нестандартных решений отметим необычное расположение контактов питания: два 6-pin гнезда стоят не в линию, а друг над другом.

Для тестов мы собрали стенд на основе материнки Gigabyte GA-X58A-UD3R . В качестве процессора использовали Core i7-920 , памяти поставили три планки Kingston HyperX DDR3-1666 МГц по 2 Гб каждая, Windows 7 Ultimate 64-bit и все программы записали на Kingston SSDNow .

В список приложений вошли 3DMark11 , Unigine Heaven Benchmark 2.5 , Just Cause 2 , DiRT 2 , Aliens vs. Predator , Batman: Arkham City и Total War: Shogun 2 . В конкуренты были назначены GeForce GTX 590 , GTX 580 , AMD Radeon HD 6970 и HD 7970 .

Кто первый?

В 3DMark11 новинка оказалась на 17% быстрее HD 7970 и приблизилась к итогам двойной GTX 590! Понравился Kepler и жадному до ресурсов Unigine Heaven Benchmark 2.5: превосходство над AMD — 26%. В играх цифры получились еще интереснее.

В Aliens vs. Predator флагман «зеленых» показал 57,7 fps, опередив GTX 580 с HD 6970 и отстав от HD 7970 и GTX 590 на 1,5 и 15,8 кадра соответственно. Проиграл новичок и в Just Cause 2, которая оптимизирована под драйвера AMD, — разница с HD 7970 составила 21,7 fps. Отличиться удалось в DiRT 2, «красный» лидер упустил 37,5 fps.

Следующая победа NVIDIA — Batman: Arkham City. При включенном на максимум PhysX, MSAA 8x и разрешении 1920х1080 герой нашего обзора выдал вполне играбельные 26 fps, в то время как HD 7970 еле дотянулась до 20 кадров. После отключения PhysX ситуация не изменилась: с MSAA 4х отрыв составлял 4-6 fps, а после перехода на 8х — 15-18 fps. Триумфальное шествие GTX 680 остановила Total War: Shogun 2. Старший GeForce добрался до 23,2 fps, HD 7970 — до 24,9.

Последнее слово

Скажем прямо, от GeForce GTX 680 мы ждали большего. Посмотрите на итоговое соотношение fps: всего на 8% быстрее HD 7970. Такая же разница два года назад была между GTX 580 и HD 6970. Да, во многих приложения «зеленый» флагман на голову превосходит своего конкурента. Но все это лишь оптимизированные под NVIDIA игры. В беспристрастных тестах — Aliens vs. Predator, Batman: Arkham City, Total War: Shogun 2 —соперники идут вровень.

Сегодняшняя победа GTX 680, вполне возможно, заслуга позднего выхода. Появись GeForce раньше HD 7970, и инженеры AMD кровь из носу, но подтянули бы Graphics Core Next до частот Kepler. Что бы из этого вышло — смотрите наши таблички. Мы разогнали HD 7970 до средней скорости GK104 — 1035 МГц — и получили похожие с GTX 680 результаты.

Назвать GTX 680 безоговорочным лидером невозможно. По производительности карта ненамного опережает HD 7970. Пожалуй, единственное преимущество Kepler — технологичность. Автоматический разгон по запасу TDP, оригинальные режимы сглаживания, возможность играть на трех мониторах, отдельный чип декодирования видео, PhysX, 3D Vision, шумоизоляция системы охлаждения. И все это при крайне скромном энергопотреблении в 195 Вт. В остальном AMD и NVIDIA примерно равны. И сейчас все зависит от грамотной поддержки, настройки драйверов и, конечно, ценовой политики компаний. К примеру, HD 7970 уже можно купить за 16 500 рублей, официальный ценник на GTX 680 — 17 990 рублей.

Мысли вслух

Если немного отвлечься от результатов Kepler и повнимательнее присмотреться к характеристикам, то можно заметить много интересного. GTX 680 выглядит слишком странно для топовой видеокарты. Первое, что бросается в глаза, — заметное упрощение подсистемы памяти: всего 256 против 384 бит у GTX 580. Дальше — больше. Энергопотребление новинки на удивление мало — 195 Вт. И хотя это соответствует современным тенденциям увеличения производительности на ватт, все мы знаем, что NVIDIA никогда не стеснялась делать большие и горячие чипы, которые потребляли по 250 Вт. Смущает и подозрительно скромный объем GDDR5 — всего 2 Гб, и это у платы, которая должна обеспечивать сумасшедшее разрешение 5760х1080 при игре на трех мониторах. Кстати, о последнем: GK104 поддерживает всего четыре дисплея одновременно, хотя вполне мог бы потянуть и шесть, как старшие представители AMD. Ну и, наконец, ничтожно маленький прирост элементов и скромная площадь ядра. А ведь NVIDIA никогда не стремилась к минимализму.

Проводя параллели с прошлыми поколениями, складывается ощущение, что перед нами урезанная версия кристалла и в скором времени нас вполне может ожидать что-то помощнее. Конечно, это всего лишь мысли вслух, и, возможно, NVIDIA действительно пошла против собственных принципов, но очень уж GTX 680 похожа на какую-нибудь GTX 670.

В основной части статьи мы упомянули несколько новых технологий. Расскажем о них подробнее. Начнем с Adaptive VSync.

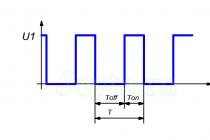

У любого монитора есть собственная частота развертки. Для современных ЖК-панелей она составляет 60 или 120 Гц при поддержке 3D Stereo. Эти цифры указывают на максимальное количество кадров, которое экран может показать за одну секунду. Однако в некоторых играх fps переходит эту границу. С одной стороны, это хорошо — никаких тормозов. С другой — превышение развертки приводит к подергиваниям изображения.

VSync позволяет подогнать частоту обновления под возможности монитора. Если матрица ограничена 60 Гц, то больше 60 fps видеокарта не выдаст, а значит, не будет искажения картинки. Но есть у такого подхода один существенный минус. Когда GPU не может обеспечить нужное число кадров, VSync выставляет планку «не больше» 30, потом 20 и 10 fps. И не обращает внимания, что карта легко держит, к примеру, 40 fps. В NVIDIA решили эту проблему.

Adaptive VSync отслеживает производительность системы, и если скорость падает ниже 60 fps — отключает VSync, не давая плате простаивать. Как только игра набирает обороты, ограничение возвращается. Итог: отсутствие артефактов и искусственных зависаний.

Сглаживание

Следующими на повестке дня значатся новые методы сглаживания, призванные заменить привычный Multisampling Antialiasing. Чтобы понять, чем же плох стандартный MSAA, надо разобраться с принципами его работы.

Технология была придумана для избавления от алиасинга по углам объектов. Неприятные зазубрины появляются по очень простой причине. ЖК-панель можно представить как лист тетрадки в мелкую клеточку, каждую из которых разрешается закрасить одним цветом. Попробуйте нарисовать по этим правилам какой-нибудь домик: горизонтальные и вертикальные линии получатся ровными, а наклонные — «елочкой». В компьютере все то же самое. Видеокарта превращает фигуры в пиксели (этим занимаются блоки ROP) и заполняет ими экран. Так как точек у дисплея немного, на неровных плоскостях вылезают характерные «зубчики». Избавиться от них сравнительно просто: надо соседние с краями предметов пиксели перекрасить в переходные цвета. Чтобы их определить — и используют антиалиасинг.

Сначала для этого применяли SuperSampling: сцена рендерилась в разрешении в 2/4/8 раз выше нужного, потом картинка сжималась до возможностей матрицы и выводилась на монитор — зазубрины исчезали. Одно плохо — такой подход потреблял неприлично много ресурсов, поэтому вскоре его сменил Multisampling. При помощи хитрых алгоритмов он обрабатывал исключительно проблемные места и не трогал остальную часть изображения, что позволяло заметно увеличить производительность.

К сожалению, с ростом количества полигонов и появлением новых сложных эффектов эта технология оказалась неэффективна: потери в скорости перестали соответствовать увеличению качества. Плюс много проблем стали создавать движки с отложенным рендерингом. Они сначала рассчитывают геометрию и только потом накладывают освещение. Яркий пример — «Метро 2033», где включение MSAA приводило к чудовищному падению fps. В общем, трудностей с современным антиалиасингом хватает, и производители ищут ему альтернативу.

Первой ласточкой стала Morphological AA, анонсированная с AMD Radeon HD 6970. Видеокарта рендерит кадр в стандартном разрешении и применяет к нему легкий «фотошоп» — размывает изображение. В результате никаких «зазубрин», но при этом теряется четкость текстур. Такой же прием теперь использует NVIDIA, правда, зовет его FXAA.

А вот TXAA — это уже кое-что новенькое. Он сочетает в себе как традиционные способы антиалиасинга, так и постобработку на основе HDR и информации из предыдущих кадров. Итоговый результат по качеству превышает MSAA 8x, а ресурсов потребляет меньше, чем MSAA 4x.

Отметим, что все эти нововведения — не игры маркетологов. Мы провели тест, в котором сравнили MSAA и FXAA. Разница в производительности составила 10%. Результат вы можете увидеть на приведенных рядом скриншотах. FXAA выглядит не так красиво, как традиционный MSAA, однако в динамике это почти не заметно.

К сожалению, проверить новенький TXAA нам не удалось. Он должен быть встроен в игру; о его поддержке в будущих проектах уже заявили Epic , Crytek , Gearbox и CCP .

Разгон

GPU Boost, реализованный в GTX 680, давно просился на видеокарты. В центральных процессорах автоматический разгон используют еще со времен первых Core i7. В GPU он проник лишь с появлением GTX 580, да и то в урезанном виде. Технология предназначалась для защиты от перегрева: понижала скорость при превышении TDP. Таким образом NVIDIA оберегала свои чипы от специальных грелок типа FurMark и могла существенно увеличить итоговые частоты работы. Минусом старого подхода была реализация: управляли всем драйвера, которые реагировали на заранее прописанные приложения.

Эту ошибку исправили в AMD. PowerTune, представленная с Radeon HD 6970, тоже боролась с перегревом, но за температурой следили встроенные в кристалл датчики, которые оказывались значительно расторопнее программных решений и не зависели от конкретных программ.

В GTX 680 инженеры пошли еще дальше. Аппаратные средства контроля теперь разгоняют GPU. Когда игра не может полностью нагрузить камень и есть запас по TDP, быстродействие платы увеличивается. Как только достигается максимальный уровень энергопотребления, карта сбавляет обороты. Интересно, что заявленные 1056 МГц не предел для GPU Boost. В наших тестах Kepler нередко поднимался до отметки 1100 МГц.

Единственный негативный момент — «допинг» невозможно отключить. Даже при повышении базовой частоты GPU Boost продолжает работать. Так, выставив Base Clock на 1100 МГц, мы были свидетелями того, как GK104 добрался до 1300 МГц! Правда, жаловаться на это будут только профессиональные тестеры, нам с вами «бесплатная» прибавка никогда не помешает.

Физика

Еще одна новость — обновление PhysX. С GTX 680 он получил два свежих эффекта. Первый — доработанная версия расчета волос. Если на GTX 580 демонстрировались отдельные пряди, то на презентации Kepler нам показали техническое демо c натуральным йети, каждый волосок которого реагировал на внешние воздействия вроде ветра или поглаживания.

Второй — возможность разрушения объектов. NVIDIA научила движок разбивать предметы в реальном времени. И не просто рассчитывать анимацию заранее заготовленных блоков, а натурально разламывать целые колонны, накладывать текстуры на получившиеся обломки и раскидывать их по всем законам физики.

Таблица 1.

Технические характеристики

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Количество транзисторов |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Техпроцесс |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Количество потоковых процессоров |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Частота графического ядра |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Частота потоковых процессоров |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Тип, объем памяти |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Частота памяти |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Шина данных |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Количество текстурных блоков |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Количество блоков растеризации |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Энергопотребление |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Длина платы |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Интерфейс |

|

|

NVIDIA GeForce GTX 690 |

|

|

AMD Radeon HD 7970 |

|

|

AMD Radeon HD 7950 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

Цена на январь 2012 года |

|

|

NVIDIA GeForce GTX 690 |

17 990 рублей |

|

AMD Radeon HD 7970 |

16 500 рублей |

|

AMD Radeon HD 7950 |

15 000 рублей |

|

AMD Radeon HD 6970 |

10 000 рублей |

|

NVIDIA GeForce GTX 580 |

12 500 рублей |

|

NVIDIA GeForce GTX 590 |

23 500 рублей |

Таблица 2.

Синтетические тесты

3DMark11

|

NVIDIA GeForce GTX 680 |

|

|

VTX Radeon HD 6970 |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Unigine Heaven Benchmark 2.5

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Таблица 3.

Игровые тесты (кадров в секунду)

Aliens vs. Predator (DX11)

|

VeryHigh. 1680x1050, AF 16x, AA 2x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

VeryHigh, 1920x1080, AF 16x, AA 2x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

DiRT 2 (DX11)

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Just Cause 2

|

High, 1680x1050, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

High, 1920x1080, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Batman: Arkham City (DX11, Full PhysX)

|

High, 1680x1050, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

High, 1680x1050, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

High, 1920x1080, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

High, 1920x1080, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

XFX R7970 Double Dissipation (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Batman: Arkham City (DX11, no PhysX)

|

Ultra. 1680x1050, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1680x1050, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1920x1080, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1920x1080, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Total War: Shogun 2 (DX11)

|

Ultra. 1680x1050, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1680x1050, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1920x1080, AF 16x, AA 4x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

Ultra, 1920x1080, AF 16x, AA 8x |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

ASUS HD 7970 DirectCU II Top (925/5500 МГц) |

|

|

ASUS HD 7970 DirectCU II Top (1035/5500 МГц) |

|

|

VTX Radeon HD 6970 |

|

|

ZOTAC GeForce GTX 580 AMP! Edition (772/4008 МГц) |

|

|

Point of View GeForce GTX 590 |

|

Таблица 4.

Соотношение цена/производительность

|

Производительность |

|

|

NVIDIA GeForce GTX 680 |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

|

NVIDIA GeForce GTX 680 |

|

|

AMD Radeon HD 7970 (925/5500 МГц) |

|

|

AMD Radeon HD 7970 (1035/5500 МГц) |

|

|

AMD Radeon HD 6970 |

|

|

NVIDIA GeForce GTX 580 |

|

|

NVIDIA GeForce GTX 590 |

|

1. Обзор видеокарты Gigabyte GeForce GTX 680 SOC WindForce 5X 2 Гбайт (GV-N680SO-2GD)

технические характеристикиТехнические характеристики видеокарты Gigabyte приведены в таблице в сравнении с эталонной видеокартой NVIDIA GeForce GTX 680:

упаковка и комплектация

Видеокарта поставляется в большой картонной коробке, на лицевой стороне которой приведена ключевая информация о продукте:

На обратной – подробное описание системы охлаждения, используемых технологий, фирменной утилиты для разгона и мониторинга, а также прочая, менее значительная информация.

В комплекте поставки два кабеля-переходника с PATA-разъёмов на восьмиконтактные, компакт-диск с драйверами и утилитами, инструкция по установке и рекламный буклет:

Прямо скажем, комплектация для продукта верхнего ценового сегмента очень скромная.

Gigabyte GeForce GTX 680 SOC WindForce 5X выпускается в Тайване и стоит 549 долларов США. Гарантия на продукт – 3 года.

особенности

Видеокарта имеет размеры 295х120х64 мм и выглядит монументально, напоминая собой эдакий броненосец:

Вместо привычных вентиляторов или турбины на лицевой стороне видеокарты мы видим металлический пластиковый кожух с декоративными прорезями, названием компании-производителя и лейблами «Super OverClock». Обратная сторона видеокарты также закрыта металлической пластиной с перфорацией.

Сверху виден ряд из пяти маленьких вентиляторов, частично накрытых металлической пластиной, а снизу – массивный радиатор с тепловыми трубками:

Gigabyte GeForce GTX 680 SOC WindForce 5X оснащается двумя DVI выходами (один с Dual Link), одним выходом HDMI версии 1.4а и одним выходом DisplayPort версии 1.2:

С другой стороны видеокарты видны сразу три разъёма для вентиляторов и какой-то интерфейсный выход непонятного назначения.

Два разъёма MIO для создания различных SLI-конфигураций размещены на своих стандартных местах: в верхней части печатной платы видеокарты у её выходов:

А вот стандартные шести- и восьмиконтактные разъёмы питания, инженеры Gigabyte заменили на два восьмиконтактных, стремясь обеспечить необходимый запас тока при работе на повышенных частотах. Рекомендуемая мощность блока питания для системы с одной такой видеокартой заявлена на отметке 650 ватт, что на 100 ватт выше спецификаций эталонной NVIDIA GeForce GTX 680.

Печатная плата Gigabyte GeForce GTX 680 SOC WindForce 5X выполнена по оригинальному дизайну и имеет усиленную систему питания:

За обеспечение питания графического процессора отвечают сразу восемь фаз, а ещё три отведены на питание памяти и силовых цепей:

Видеокарта относится к серии Super Overclock , построенной по концепции применения высококачественных компонентов с увеличенным сроком службы, японских конденсаторов, пленочных конденсаторов Proadlizer NEC/TOKIN с низким эквивалентным последовательным сопротивлением ESR, установленных на обратной стороне печатной платы:

За управление питанием графического процессора отвечает восьмифазный цифровой PWM-контроллер CHiL CHL8318 :

В верхней части платы видна группа контактов J13, являющейся точками для замера рабочих напряжений V-PLL, V-MEM и V-GPU. Это не столь удобно, как, например, у MSI, но всё же редкие видеокарты оснащены такой возможностью.

Кроме всего вышеперечисленного, видеокарта оснащена двумя версиями BIOS, которые можно переключать квадратной кнопкой с подсветкой, размещённой у выходов платы. В обычной версии (синяя подсветка) просто зашиты повышенные частоты, а вот при переключении на так называемую экстремальную версию BIOS видеокарты (красная подсветка) снимаются все ограничения по токам, и до 300% увеличивается предел мощности графического процессора. Этот BIOS предназначен для экстремального оверклокинга при сверхнизких температурах.

Графические процессоры для видеокарт Gigabyte серии Super Overclock проходят специальную систему отбора «GPU Gauntlet» посредством нескольких циклов стресс-тестирования. В итоге на такие видеокарты устанавливаются только наиболее качественные чипы с высоким оверклокерским потенциалом. Наш кристалл GK104 выпущен в Тайване на 25-й неделе 2012 года (середина июня) и относится к ревизии А2:

Его базовая частота повышена с 1006 до 1137 МГц или сразу на 13%, а в моменты высокой нагрузки частота может увеличиваться до 1202 МГц. Во всём остальном это обычный «Kepler» с напряжениями 1,175 В для 3D-режима и 0,988 В – для 2D-режима, в котором частота снижается до 324 МГц.

На видеокарте установлено 2 Гбайт GDDR5-памяти производства компании Samsung с маркировкой K4G20325FD-FC03 :

Её эффективная частота повышена с номинальных 6008 МГц до 6200 МГц или +3,2%, что совсем немного, но вполне себе приятный бонус. В 2D-режиме частота видеопамяти снижается до 648 МГц.

В итоге спецификации Gigabyte GeForce GTX 680 SOC WindForce 5X таковы:

Добавим, что BIOS видеокарты Gigabyte GeForce GTX 680 SOC WindForce 5X вы можете скачать из нашего файлового архива (BIOS Gigabyte GeForce GTX 680 SOC WindForce 5X , и перейдём к изучению системы охлаждения WindForce 5X.

система охлаждения WindForce 5X

Какой бы ни была печатная плата видеокарты Gigabyte GeForce GTX 680 SOC WindForce 5X, всё это, по большому счёту, мы с вами уже видели ранее в продуктах ASUS, MSI и самой Gigabyte. Поистине уникальной в этом продукте является система охлаждения WindForce 5X. В компании не скрывают, что гордятся этой разработкой, и оригинальности ей действительно не занимать, ведь в её конструкции скомбинированы тепловая камера, девять медных тепловых трубок диаметром 6 мм, гигантский алюминиевый радиатор и пять 40-мм вентиляторов:

Несмотря на огромную массу (вес видеокарты с кулером 1622 (!) грамма), крепится он к печатной плате всего шестью винтами, четыре из которых расположены по углам графического процессора и два на радиаторе для силовых элементов:

Защитный кожух снять чуть более сложно, но без него становится ясно, что кожух этот в большей степени декоративный, нежели защитный:

Как видим, боковые стороны радиатора плотно закрыты загнутыми и сомкнутыми друг с другом рёбрами, а длинная стальная планка служит креплением для самого кожуха и не более того.

При толщине радиатора 45 мм понятно, что тепловая камера не смогла бы равномерно распределить весь тепловой поток по рёбрам, поэтому инженеры Gigabyte оснастили радиатор сразу девятью медными тепловыми трубками диаметром 6 мм. Четыре выходят в одну сторону, а пять – в другую, но все они равномерно пронизывают верхнюю часть рёбер радиатора:

Контакт основания кулера с графическим процессором осуществлён посредством густой и серой термопасты, а с микросхемами памяти и силовыми элементами радиатор контактирует через термопрокладки. Все сопряжения в радиаторе пропаяны.

Сразу пять 40-мм вентиляторов, установленных на верхнем торце радиатора, выпущены компанией Power Logic (модель PLA04015S12HH), базируются на подшипниках качения и управляются широтно-импульсной модуляцией (PWM):

Вентиляторы установлены в перевёрнутом виде, то есть в процессе работы они будут выдувать горячий воздух из радиатора, засасывая его снизу. И если на боковой стенке вашего корпуса нет вентилятора «на выдув», то нагретый видеокартой воздух будет оставаться внутри корпуса и его придётся выводить другими корпусными вентиляторами.

Давайте проверим, сколь эффективен кулер WindForce 5X. Для этого в качестве нагрузки мы использовали пять циклов теста весьма ресурсоёмкой игры Aliens vs. Predator (2010) при максимальном качестве графики в разрешении 2560х1440 пикселей с анизотропной фильтрацией уровня 16х и с использованием MSAA-сглаживания степени 4x:

Для мониторинга температур и прочих параметров применялись программа MSI Afterburner версии 2.2.5 и утилита GPU-Z версии 0.6.6 . Все тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при комнатной температуре 24 градуса Цельсия. Тестирование эффективности системы охлаждения видеокарты было проведено до её разборки с использованием штатного термоинтерфейса.

Посмотрим на эффективность кулера Gigabyte GeForce GTX 680 SOC WindForce 5X в автоматическом режиме работы и при максимальной скорости вентиляторов:

Автоматический режимМаксимальная мощность

При автоматической регулировке вращения вентиляторов, когда их скорость (если верить данным мониторинга) увеличивалась до 7260 об/мин, графический процессор прогрелся до 68 градусов Цельсия, что для разогнанного GK104 является превосходным результатом. Если же выставить скорость вентиляторов на максимум (9750 об/мин по данным мониторинга), то температура графического процессора составила всего 54 градуса Цельсия. Это как-то даже смешно для разогнанной GeForce GTX 680. Зато совсем не смешно для слуха пользователя.

К сожалению, традиционных измерений уровня шума в сегодняшней статье не будет. Причин тому две. Во-первых, для подключения пяти вентиляторов к печатной плате используются сразу три коннектора двух разных типов, поэтому подключить их к нашему прибору для мониторинга и управления не представлялось возможным. Второй причиной явился один бракованный вентилятор, как раз тот, который мы сняли на фото выше. При включении его подшипник завывал так, что терпеть его было крайне сложно. Правда, после прогрева он несколько утихомиривался, но всё равно лучшего решения, чем принудительно остановить его мы не нашли. К слову, температурные тесты проведены при всех пяти активированных вентиляторах. Субъективно, без гремящего подшипником вентилятора, кулер WindForce 5X работает тихо до 4000-4500 об/мин, комфортно до 6000 об/мин, а выше этой отметки, увы, уже заметно выделяется на фоне тихого системного блока. Как вы помните, в автоматическом режиме работы вентиляторы раскручивались до 7260 об/мин, поэтому мы не можем назвать Gigabyte GeForce GTX 680 SOC WindForce 5X тихой видеокартой. Только в 2D-режиме, когда скорость вентиляторов находится у отметки 2000 об/мин, видеокарту действительно не слышно, хотя для игрового продукта это не столь важно.

оверклокерский потенциал

Изучение оверклокерского потенциала Gigabyte GeForce GTX 680 SOC WindForce 5X мы начали при штатном напряжении 1,175 В и максимальном значении Power limit. Система охлаждения функционировала в автоматическом режиме. Базовую частоту графического процессора нам удалось поднять на 65 МГц, а частоту видеопамяти на 1120 эффективных мегагерц:

В результате частоты видеокарты составили 1202/1267/7328 МГц:

Результат разгона GPU вполне обычный для GeForce GTX 680, и большего нам не удалось добиться ни при включении экстремального BIOS видеокарты, ни при повышении напряжения на графическом процессоре. Впрочем, достигнутая частота памяти не может не радовать.

После разгона видеокарты максимальная температура графического процессора увеличилась на 3 градуса Цельсия до 71 градуса, а скорость вентиляторов повысилась на 150 об/мин при итоговых 7410 об/мин:

В завершение обзора видеокарты нельзя не сказать несколько слов о фирменной утилите Gigabyte OC Guru II , способной не только контролировать все параметры Gigabyte GeForce GTX 680 SOC WindForce 5X, но и управлять ими:

Кроме возможности изменения частот, напряжений и их мониторинга, утилитой можно выполнять тонкую подстройку PWM-частот и степень загрузки графического процессора, памяти и шины PCI-Express:

В отдельном окне можно вручную настроить скорость вращения вентиляторов в зависимости от температуры, или выбрать одну из трёх предустановок:

энергопотребление

Измерение энергопотребления системы с различными видеокартами осуществлялось с помощью многофункциональной панели Zalman ZM-MFC3 , которая показывает потребление системы «от розетки» в целом (без учёта монитора). Измерение было проведено в 2D-режиме, при обычной работе в Microsoft Word или интернет-«сёрфинге», а также в 3D-режиме, нагрузка в котором создавалась с помощью трёхкратного теста из игры Metro 2033: The Last Refuge в разрешении 2560х1440 при максимальных настройках качества графики.

Давайте посмотрим на результаты:

Что интересно, система с видеокартой Gigabyte оказалась немного экономичнее в плане потребления электроэнергии, чем система с почти такой же видеокартой ASUS. Даже после разгона Gigabyte GeForce GTX 680 SOC WindForce 5X до частот 1202/7320 МГц она потребляет чуть меньше, чем ASUS GeForce GTX 680 DirectCU II TOP на номинальных для неё частотах 1137/6008 МГц. В дополнение отметим, что система с Radeon HD 7970 GHz Edition (в исполнении Sapphire) всё же более требовательна к энергопотреблению, чем обе системы с GeForce GTX 680. Ну, а лидером сегодня вполне закономерно стала система с двухпроцессорной GeForce GTX 690. В 2D-режиме бездействия энергопотребление всех систем отличается в самой минимальной степени.

2. Тестовая конфигурация, инструментарий и методика тестирования

Тестирование видеокарт было проведено на системе следующей конфигурации:

Системная плата: Intel Siler DX79SI (Intel X79 Express, LGA 2011, BIOS 0537 от 23.07.2012);

Центральный процессор: Intel Core i7-3960X Extreme Edition 3,3 ГГц (Sandy Bridge-E, C1, 1,2 В, 6x256 Kбайт L2, 15 Мбайт L3);

Система охлаждения CPU: Phanteks PH-TC14PЕ (два 140 мм вентилятора Corsair AF140 Quiet Edition при 900 об/мин);

Термоинтерфейс: ARCTIC MX-4 ;

Оперативная память: DDR3 4x4 Гбайт Mushkin Redline (2133 МГц, 9-10-10-28, 1,65 В);

Видеокарты:

NVIDIA GeForce GTX 690 2x2 Гбайт 256 бит GDDR5, 915/6008 МГц;

Gigabyte GeForce GTX 680 SOC WindForce 5X 2 Гбайт 256 бит GDDR5, 1137/6200 и 1202/7320 МГц;

ASUS GeForce GTX 680 DirectCU II TOP 2 Гбайт 256 бит GDDR5, 1137/6008 МГц;

Sapphire Radeon HD 7970 OC Dual-X 3 Гбайт 384 бит GDDR5, 1050/6000 МГц;

Системный диск: SSD 256 Гбайт Crucial m4 (SATA-III, CT256M4SSD2, BIOS v0009);

Диск для программ и игр: Western Digital VelociRaptor (SATA-II, 300 Гбайт, 10000 об/мин, 16 Мбайт, NCQ) в коробке Scythe Quiet Drive 3,5";

Архивный диск: Samsung Ecogreen F4 HD204UI (SATA-II, 2 Тбайт, 5400 об/мин, 32 Мбайт, NCQ);

Корпус: Antec Twelve Hundred (передняя стенка – три Noiseblocker NB-Multiframe S-Series MF12-S2 на 1020 об/мин; задняя – два Noiseblocker NB-BlackSilentPRO PL-1 на 1020 об/мин; верхняя – штатный 200-мм вентилятор на 400 об/мин);

Панель управления и мониторинга: Zalman ZM-MFC3 ;

Блок питания: Seasonic SS-1000XP Active PFC F3 (1000 Вт), 120-мм вентилятор;

Монитор: 27" Samsung S27A850D (DVI-I, 2560х1440, 60 Гц).

Производительность видеокарты Gigabyte мы сравним с очень быстрой ASUS GeForce GTX 680 DirectCU II TOP на номинальных частотах и с Sapphire Radeon HD 7970 OC Dual-X , разогнанной до уровня GHz Edition :

Кроме того, в качестве ориентира по скорости в тестирование добавлена эталонная NVIDIA GeForce GTX 690 на своих номинальных частотах:

Для снижения зависимости производительности видеокарт от скорости платформы, 32-нм шестиядерный процессор при множителе 37, опорной частоте 125 МГц и активированной функции «Load-Line Calibration» был разогнан до 4,625 ГГц при повышении напряжения в BIOS материнской платы до 1,49 В:

Технология «Hyper-Threading» активирована. При этом 16 Гбайт оперативной памяти функционировали на частоте 2 ГГц с таймингами 9-11-10-28 при напряжении 1,65 В.

Тестирование, начатое 3 ноября 2012 года, было проведено под управлением операционной системы Microsoft Windows 7 Ultimate x64 SP1 со всеми критическими обновлениями на указанную дату и с установкой следующих драйверов:

чипсет материнской платы Intel Chipset Drivers – 9.3.0.1025 WHQL от 25.10.2012 ;

библиотеки DirectX End-User Runtimes, дата выпуска – 30 ноября 2010 года ;

драйверы видеокарт на графических процессорах AMD – Catalyst 12.11 Beta от 23.10.2012 + Catalyst Application Profiles 12.10 (CAP1);

драйверы видеокарт на графических процессорах NVIDIA – GeForce 310.33 beta от 23.10.2012 .

Производительность видеокарт была проверена в двух разрешениях: 1920х1080 и 2560х1440 пикселей. Для тестов были использованы два режима качества графики: «Quality + AF16x» – качество текстур в драйверах по-умолчанию с включением анизотропной фильтрации уровня 16х, и «Quality + AF16x + MSAA 4х(8х)» с включением анизотропной фильтрации уровня 16х и полноэкранного сглаживания степени 4x или 8x, в случаях, когда среднее число кадров в секунду оставалось достаточно высоким для комфортной игры. Включение анизотропной фильтрации и полноэкранного сглаживания выполнялось непосредственно в настройках игр. Если данные настройки в играх отсутствовали, то параметры изменялись в панелях управления драйверов Catalyst и GeForce. Там же была отключена вертикальная синхронизация. Больше никаких изменений в настройки драйверов не вносились.

Так как мы неоднократно тестировали GeForce GTX 680 и его конкурента, то сегодняшний список тестовых приложений был сокращён до одного полусинтетического пакета и 8 игр (по принципу наиболее ресурсоёмких и свежих):

3DMark 2011 (DirectX 11) – версия 1.0.3.0, профили настроек «Performance» и «Extreme»;

Metro 2033: The Last Refuge (DirectX 10/11) – версия 1.2, использовался официальный тест, настройки качества «Very High», тесселляция, DOF включено, использовалось ААА-сглаживание, двойной последовательный проход сцены «Frontline»;

Total War: SHOGUN 2 – Fall of the Samurai (DirectX 11) – версия 1.1.0, встроенный тест (битва при Sekigahara) на максимальных настройках качества графики и использовании в одном из режимов MSAA 4x;

Crysis 2 (DirectX 11) – версия 1.9, использовался Adrenaline Crysis 2 Benchmark Tool v1.0.1.14 BETA , профиль настроек качества графики «Ultra High», текстуры высокого разрешения активированы, двукратный цикл демо-записи на сцене «Times Square»;

Battlefield 3 (DirectX 11) – версия 1.4, все настройки качества графики на «Ultra», двойной последовательный проход заскриптованной сцены из начала миссии «На охоту» продолжительностью 110 секунд;

Sniper Elite V2 Benchmark (DirectX 11) – версия 1.05, использовался Adrenaline Sniper Elite V2 Benchmark Tool v1.0.0.2 BETA максимальные настройки качества графики («Ultra»), Advanced Shadows: HIGH, Ambient Occlusion: ON, Stereo 3D: OFF, двойной последовательный прогон теста;

Sleeping Dogs (DirectX 11) – версия 1.5, использовался Adrenaline Sleeping Dogs Benchmark Tool v1.0.0.3 BETA , максимальные настройки качества графики по всем пунктам, Hi-Res Textures pack установлен, FPS Limiter и V-Sync отключены, двойной последовательный прогон теста с суммарным сглаживанием на уровне «Normal» и на уровне «Extreme»;

F1 2012 (DirectX 11) – update 9, использовался Adrenaline Racing Benchmark Tool v1.0.0.13 , настройки качества графики на уровне «Ultra», бразильская трасса «Interlagos» 2 круга, 24 машины, лёгкий дождь, режим камеры – «Bonnet»;

Borderlands 2 (DirectX 9) – версия 1.1.3, встроенный тест при максимальных настройках качества графики и максимальном уровне PhysX, сглаживание FXAA включено.

Если в играх реализована возможность фиксации минимального числа кадров в секунду, то оно также отражалось на диаграммах. Каждый тест проводился дважды, за окончательный результат принималось лучшее из двух полученных значений, но только в случае, если разница между ними не превышала 1%. Если отклонения прогонов тестов превышали 1%, то тестирование повторялось ещё, как минимум, один раз, чтобы получить достоверный результат.

Borderlands 2

Мы не стали комментировать каждую диаграмму, так как, по большому счёту, ничего нового на них не увидели. В целом Gigabyte GeForce GTX 680 SOC WindForce 5X чуть быстрее ASUS GeForce GTX 680 DirectCU II TOP за счёт более скоростной памяти, но разница мизерна. Разгон Gigabyte приносит ей 5-7% производительности плюсом, что также немного, но и пренебрегать таким бесплатным повышением производительности не стоит. В противостоянии с Sapphire Radeon HD 7970 OC Dual-X на частотах 1050/6000 МГц на новых версиях драйверов новая видеокарта Gigabyte выигрывает в 3DMark 2011, Crysis 2, Borderlands 2, а также качественных режимах Total War: SHOGUN 2 и F1 2012. Паритет у этих видеокарт только в Battlefield 3. В свою очередь, Radeon опережает GeForce в Metro 2033: The Last Refuge, Sniper Elite V2, Sleeping Dogs, а также в режимах без использования сглаживания Total War: SHOGUN 2 и F1 2012. Из особенностей работы двухпроцессорной NVIDIA GeForce GTX 690 на новых драйверах и в новых тестах выделим отсутствие поддержки SLI в игре F1 2012, а остальные тесты сюрпризов не преподнесли.

Заключение

Gigabyte GeForce GTX 680 SOC WindForce 5X, безусловно, оказалась очень интересной видеокартой. Досконально проработанная печатная плата с восьмифазной системой питания графического процессора и применением высококачественных компонентов для серии «Super Overclock» обеспечат стабильность при разгоне и долговечность эксплуатации. Отобранный по специальной программе «GPU Gauntlet» графический процессор, дополнительный BIOS c настройками для разгона под азотом и точки для замера ключевых напряжений наверняка обратят на себя внимание экстремальных оверклокеров. Высокие заводские частоты вкупе с весьма эффективной системой охлаждения WindForce 5X и конкурентоспособной стоимостью просто не могут не привлечь большинство обычных пользователей.

В то же время, систему охлаждения этого стильного и внешне монументального продукта мы не можем назвать тихой. Вдобавок, для раскрытия потенциала ей требуется просторный корпус с грамотно организованной системой вентиляции. Кроме того, у продуктов такого класса должна быть более насыщенная и притягивающая комплектация, а в качестве морального успокоения флагманский продукт Gigabyte можно было и оснастить четырьмя гигабайтами памяти вместо нынешних двух. Тем не менее, о Gigabyte GeForce GTX 680 SOC WindForce 5X у нас сложилось позитивное впечатление. Выбор, как и всегда, за вами.

22 марта 2012 была представлена супер-новинка от компании NVIDIA – видеокарта архитектуры Kepler – NVIDIA GeForce GTX 680 . Очередной технологический прорыв от инженеров принес больше энергоэффективности, больше производительности. Разумеется, больше денег от народонаселения. Оценить возможности карты нового поколения я смогу на примере ASUS GeForce GTX 680.

Видеокарта ASUS поставляется в картонной коробке, бэкграунд которой оформлен как состаренный металл, разорванный когтями неведомого хищника. Пиктограмма напоминает нам, что фирменная утилита GPU Tweak придет на помощь, если вы захотите разгнать и тонко настроить видеокарту прямо в режиме реального времени. Кроме того ASUS говорит о 2 гигабайтах видеопамяти, поддержке DirectX 11 и шины PCI-Express 3.0.

Обратная сторона, как водится, оставлена для описания фирменных примочек и технологий, среди которых GPU Boost и адаптивная вертикальная синхронизация. GPU Boost является некоторым аналогом технологии Intel с то разницей, что процессоры увеличивают множитель, а видеокарта добавляет частоту просто мегагерцами. C помощью программ можно задать лимит тепловыделение и попробовать разогнать видеокарту выше чем частота Boost Clock. Немного забегая вперед скажу, что с разгоном у GeForce GTX 680 все в порядке.

Видеокарта ASUS GeForce GTX 680 является копией референсного образца. Оригинальные решения инженеров применяются на других моделях, например DirectCu II, которые надеюсь попадут ко мне на тесты.

Для питания видеоядра используется четырехфазная система питания. Видеопамять получает питания по двухфазной схеме.

Дополнительное питание на видеокарту подается через два разъема PCI Express 6-pin. Расположение их весьма необычно, друг над другом, при этом дальний от платы разъем утоплен на сантиметр по высоте.Энергопотребление составляет 195 ватт и производитель рекомендует использовать как минимум 550-ваттный блок питания.

Видеокарта поддерживает одновременное подключение четырех мониторов, для чего на ней разведены четыре видеовыхода — два DVI, HDMI 1.4a и DisplayPort.

Ядро охлаждается с помощью небольшого радиатора. Сложная конструкция с использованием трех плоских тепловых трубок справляется с температурой на отлично.

Отдельная металлическая пластина закрывает плату целиком и охлаждает чипы видеопамяти и силовые элементы на плате. Обдувается вся система с помощью вентилятора турбинного типа.

Для тестирования производительности системы была собрана следующая система:

Процессор |

|

Материнская плата |

|

Видеокарта |

|

Оперативная память |

|

Блок питания |

|

Жесткий диск |

|

Корпус |

|

Монитор |

|

Клавиатура |

|

Мышь |

|

Набор тестовых приложений с настройками:

Синтетические тесты:

- 3D Mark 11, пресеты Entry, Performance, Extreme

- 3D Mark Vantage, пресет Performance

- Unigine Heaven HWBOT Edition, DX 11, Extreme preset

Игровые тесты:

- Aliens vs Predator DX11 Benchmark, 1920*1080

- Dirt 3, 1920*1080, встроенный бенчмарк

- Metro 2033, 1920*1080, встроенный бенчмарк

- Lost Planet 2 DX 11, 1920*1080, тест производительности А

- Street Fighter benchmark, 1920*1080

Для тестирования видеокарта ASUS GeForce GTX 680 была разогнана до частот 1220 МГц по графическому ядру и 1600 МГц по видеопамяти. Для сравнения был выбран флагман предыдущего поколения — Leadtek GeForce GTX 580, текущий лидер из конкурирующего лагеря — AMD Radeon HD 7970 и двухчиповая карта предыдущего поколения — AMD Radeon HD 6990.

Раньше 3D Mark Vantage считался вотчиной карт от NVIDIA — прошли те времена. Красные впереди с серьезным отрывом.

3D Mark 11 вышел совсем недавно и результаты его более справедливы. В номинальном режиме ASUS GeForce GTX 680 немного проигрывает конкуренту в лице AMD Radeon HD 7970, но разгон позволяет подтянуться очень близко.

Игровой тест Aliens vs Predator тоже отдал предпочтение красным. Преимущество GeForce GTX 680 над предшественником составляет около 20%

Dirt3 раскрывает потенциал видеокарт NVIDIA — лидерство заслужено и закономерно.

Любовь Lost Planet 2 к графическим ускорителям NVIDIA известна и потдверждается.

Metro 2033 лучше идет на AMD Radeon, но преимущество минимально, так что скорее стоит говорить о паритете.

Эффект от разгона ASUS GeForce GTX 680 практически отсутствует, что несколько непонятно. Возможно какая то особенность драйверов или архитектуры.

Синтетический тест отдал предпочтение Radeon, но нужно учитывать, что у продукции AMD отключается тесселяция, которая активно используется в этом тесте.

Итоговые мысли.

Видеокарта ASUS GeForce GTX 680 демонстрирует высокую производительность и значительное превосходство над флагманов предыдущего поколения на ядре Fermi. В битве с красными конкурентами не всегда удается быть впереди, но это компенсируется более низким энергопотреблением и лучшими технологиями сглаживания. Стоит ожидать от нереференсных версий еще более высоких частот и тогда продукт будет еще более успешен. По моим личным предположениям потенциал у GeForce GTX 680 очень высокий. Комания ASUS наверняка сможет его использовать в правильном направлении. А пока что за высокое качество и отличную производительность ASUS GeForce GTX 680 получает награду «Наш выбор» от OCClub

Перейдём к тестам разгона. Мы попытались выжать из всех трёх видеокарт максимальную частоту кадров, обойдя штатные уровни, выбранные производителями. Как обычно, мы выставили ограничение Power Limit на максимум, а максимальное допустимое напряжение - на 1,175 В.

EVGA GeForce GTX 680 SC Signature 2:

Мы начали со штатной частоты GPU 1098 МГц, достигнув разгона до 1144 МГц. Это соответствует разгону примерно на четыре процента. Частоту памяти 1552 МГц мы смогли увеличить до 1706 МГц. С учётом эталонного дизайна печатной платы EVGA и выбранной системы охлаждения, результат можно назвать вполне приемлемым.

Gigabyte GeForce GTX 680 Super Overclock:

Из-за сложной мощной охлаждения и усиленной подсистемы питания мы ожидали получить от Gigabyte GeForce GTX 680 Super Overclock высокие результаты. Мы увеличили частоту GPU с 1137 до 1262 МГц. Это соответствует разгону примерно на 11 процентов. Память мы смогли разогнать с 1552 МГц до 1728 МГц. Конечно, мы не смогли достичь результатов видеокарты для оверклокеров , но, в целом, мы остались довольны.

Point of View TGT GeForce GTX 680 Beast:

POV / TGT установила у видеокарты Beast уже весьма высокие тактовые частоты. В любом случае, мы попытались их поднять. Мы смогли разогнать GPU с частоты 1163 МГц до 1212 МГц, что соответствует разгону более чем в четыре процента. Частоту памяти мы смогли увеличить с 1502 МГц до 1754 МГц.

Разгон привел к следующим результатам по производительности:

По энергопотреблению, температуре и уровню шума мы получили следующие результаты:

Энергопотребление всей системы под нагрузкой, Вт.

Температура под нагрузкой, градусы Цельсия.

Уровень шума под нагрузкой, дБ(А).